MongoDB中如何优雅地删除大量数据

发布时间:2025-05-22 18:52:25 发布人:远客网络

一、MongoDB中如何优雅地删除大量数据

1、在数据库管理中,删除大量数据是一个常见的需求。这不仅是为了优化数据库性能,也是清理无用数据的一种方式。定期删除数据和归档是两个关键步骤。

2、为何要清理数据库?这主要是为了保持数据的整洁和优化资源使用。定期清除不需要的数据能提高数据库的效率,减少资源消耗。对于不常用的数据,则可归档,以释放存储空间并简化管理。

3、然而,直接使用简单的DELETE操作来删除大量数据可能会引发一系列问题,尤其是对于分布式数据库。MySQL等数据库在处理大规模删除时,可能会触发流控机制,导致性能瓶颈。因此,建议采取分批删除策略,即每次删除一部分数据,分多次执行,以避免一次性操作带来的潜在风险。

4、MongoDB提供了几种删除数据的方案,包括三种常见的方法:remove、deleteMany和bulkWrite。下面分别对比这三种方法的执行效率。

5、在MongoDB中,删除数据的三种方式主要有:

6、remove:此方法直接删除指定条件下的文档。

7、deleteMany:类似remove,但通过将待删除文档的_id放入数组中,最后一次性删除。

8、bulkWrite:与deleteMany类似,同样将待删除文档的_id放入数组中,最后通过bulkWrite进行批量删除。

9、执行效率对比表明,deleteMany与bulkWrite在删除大量数据时表现较好。因此,在处理大规模数据删除时,推荐使用deleteMany配合ObjectID进行批量操作,以提高效率。

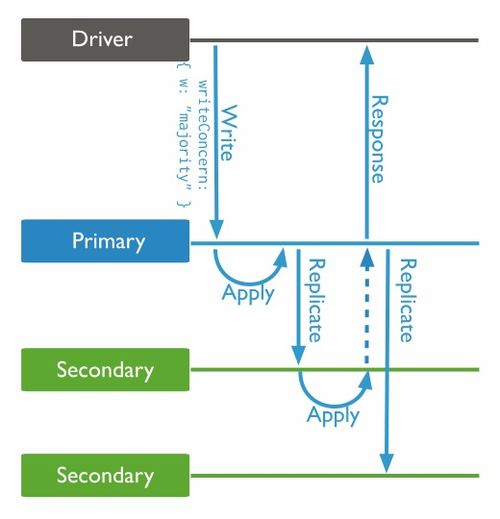

10、为了降低批量删除操作带来的主从延迟风险,MongoDB提供了Write Concern机制。通过设置Write Concern为“majority”,即等待副本集中绝大多数节点完成数据操作,可以有效规避主从延迟问题,确保数据安全。

11、在删除数据的过程中,还需注意可能出现的Bug,如程序hang在最后一批数据的删除上。这可能与操作逻辑或资源限制有关。正确的实践是,确保代码逻辑正确且资源充足,同时监控数据库性能指标,及时发现并解决潜在问题。

12、综上所述,删除大量数据时,应采用分批执行的策略,并在MongoDB中使用deleteMany配合ObjectID进行批量删除,同时利用Write Concern机制保障数据安全与操作的高效性。这些最佳实践能帮助确保数据库管理工作的顺利进行。

二、MongoDB删除数据的几种方法

在使用MongoDB数据库时,我们可能需要删除特定的数据。物理删除的数据无法找回,因此理解删除数据的方法至关重要。

使用db.connection.remove()方法能删除匹配规则的数据。若参数无效或为空,则会清空整个集合。

在进行删除操作前,首先需要准备数据。向集合中插入数据,例如集合c插入3条数据。

3.使用字母和数字组成的字符串作为参数删除所有文档(此操作危险,容易误删数据)

接下来,我们分别准备数据,并演示使用deleteOne和deleteMany方法。

1.使用deleteOne方法删除匹配的一条数据

2.使用deleteMany方法删除匹配的所有数据

值得注意的是,deleteOne和deleteMany方法不会像remove方法那样随意传入参数清空整个集合,从而避免了误删数据的风险。

总结,MongoDB数据库提供了多种删除数据的方法。其中,remove方法较为直接,但需谨慎使用。而deleteMany方法虽有误删风险,但功能更为安全。最稳妥的方法是使用deleteOne,在确保不会误删数据的前提下进行操作。

三、删除MongoDB重复数据的4种方法

1、前言

众所周知,我们常常会用MongoDB存储大量数据。然而,有时候我们忘记在建立集合的时候给某些字段设置unique属性,导致数据库中会存在大量重复的数据,这时候如何删除这些数据就成了一个令人脑壳疼的问题。在数据量较小的情况下,可以直接写一个python脚本,通过导出已有数据并插入到已建立unique索引的集合中解决问题。但是,but,如果数据量较大的话,使用脚本来解决要耗费非常大量的时间,这种时候就需要想想其他办法了

2、众所周知,我们常常会用MongoDB存储大量数据。然而,有时候我们忘记在建立集合的时候给某些字段设置unique属性,导致数据库中会存在大量重复的数据,这时候如何删除这些数据就成了一个令人脑壳疼的问题。在数据量较小的情况下,可以直接写一个python脚本,通过导出已有数据并插入到已建立unique索引的集合中解决问题。但是,but,如果数据量较大的话,使用脚本来解决要耗费非常大量的时间,这种时候就需要想想其他办法了

3、\$group中是查询条件,根据content、endTime、startTime字段来聚合相同的数据;

4、\$count用来统计重复出现的次数,\$match来过滤没有重复的数据;

5、\$addToSet将聚合的数据id放入到dups数组中方便后面使用;

6、查询结果使用forEach进行迭代id来删除数据

7、shift()作用是剔除队列中第一条id,避免删掉所有的数据;

8、db.Collection.ensureIndex({your_unique_key:1},{unique:true,dropDups:true})

9、上述命令的dropDups参数告诉MongoDB,如果遇上了unique冲突的数据,就直接删除冲突的数据

10、上述提供了四种删除MongoDB重复数据的方法,每种方法各有自己的优缺点,大家可以根据自己的需要进行选择。