如何用Python进行大数据挖掘和分析

发布时间:2025-05-24 06:21:35 发布人:远客网络

一、如何用Python进行大数据挖掘和分析

1、如何用Python进行大数据挖掘和分析?快速入门路径图

2、大数据无处不在。在时下这个年代,不管你喜欢与否,在运营一个成功的商业的过程中都有可能会遇到它。

3、大数据就像它看起来那样——有大量的数据。单独而言,你能从单一的数据获取的洞见穷其有限。但是结合复杂数学模型以及强大计算能力的TB级数据,却能创造出人类无法制造的洞见。大数据分析提供给商业的价值是无形的,并且每天都在超越人类的能力。

4、大数据分析的第一步就是要收集数据本身,也就是众所周知的“数据挖掘”。大部分的企业处理着GB级的数据,这些数据有用户数据、产品数据和地理位置数据。今天,我将会带着大家一起探索如何用 Python进行大数据挖掘和分析?

5、Python最大的优点就是简单易用。这个语言有着直观的语法并且还是个强大的多用途语言。这一点在大数据分析环境中很重要,并且许多企业内部已经在使用Python了,比如Google,YouTube,迪士尼等。还有,Python是开源的,并且有很多用于数据科学的类库。

6、现在,如果你真的要用Python进行大数据分析的话,毫无疑问你需要了解Python的语法,理解正则表达式,知道什么是元组、字符串、字典、字典推导式、列表和列表推导式——这只是开始。

7、一般可以按“数据获取-数据存储与提取-数据预处理-数据建模与分析-数据可视化”这样的步骤来实施一个数据分析项目。按照这个流程,每个部分需要掌握的细分知识点如下:

8、数据获取:公开数据、Python爬虫

9、外部数据的获取方式主要有以下两种。

10、第一种是获取外部的公开数据集,一些科研机构、企业、政府会开放一些数据,你需要到特定的网站去下载这些数据。这些数据集通常比较完善、质量相对较高。

11、另一种获取外部数据的方式就是爬虫。

12、比如你可以通过爬虫获取招聘网站某一职位的招聘信息,爬取租房网站上某城市的租房信息,爬取豆瓣评分评分最高的电影列表,获取知乎点赞排行、网易云音乐评论排行列表。基于互联网爬取的数据,你可以对某个行业、某种人群进行分析。

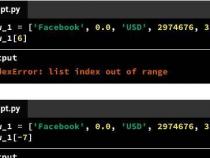

13、在爬虫之前你需要先了解一些 Python的基础知识:元素(列表、字典、元组等)、变量、循环、函数………

14、以及,如何用 Python库(urllib、BeautifulSoup、requests、scrapy)实现网页爬虫。

15、掌握基础的爬虫之后,你还需要一些高级技巧,比如正则表达式、使用cookie信息、模拟用户登录、抓包分析、搭建代理池等等,来应对不同网站的反爬虫限制。

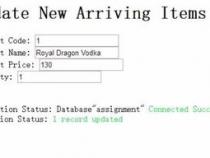

16、在应对万以内的数据的时候,Excel对于一般的分析没有问题,一旦数据量大,就会力不从心,数据库就能够很好地解决这个问题。而且大多数的企业,都会以SQL的形式来存储数据。

17、SQL作为最经典的数据库工具,为海量数据的存储与管理提供可能,并且使数据的提取的效率大大提升。你需要掌握以下技能:

18、数据的分组聚合、如何建立多个表之间的联系

19、很多时候我们拿到的数据是不干净的,数据的重复、缺失、异常值等等,这时候就需要进行数据的清洗,把这些影响分析的数据处理好,才能获得更加精确地分析结果。

20、对于数据预处理,学会 pandas(Python包)的用法,应对一般的数据清洗就完全没问题了。需要掌握的知识点如下:

21、缺失值处理:对缺失数据行进行删除或填充

22、重复值处理:重复值的判断与删除

23、异常值处理:清除不必要的空格和极端、异常数据

24、相关操作:描述性统计、Apply、直方图等

25、合并:符合各种逻辑关系的合并操作

26、分组:数据划分、分别执行函数、数据重组

27、基本统计量:均值、中位数、众数、百分位数、极值等

28、其他描述性统计量:偏度、方差、标准差、显著性等

29、其他统计知识:总体和样本、参数和统计量、ErrorBar

30、概率分布与假设检验:各种分布、假设检验流程

31、其他概率论知识:条件概率、贝叶斯等

32、有了统计学的基本知识,你就可以用这些统计量做基本的分析了。你可以使用 Seaborn、matplotlib等(python包)做一些可视化的分析,通过各种可视化统计图,并得出具有指导意义的结果。

33、掌握回归分析的方法,通过线性回归和逻辑回归,其实你就可以对大多数的数据进行回归分析,并得出相对精确地结论。这部分需要掌握的知识点如下:

34、基本的分类算法:决策树、随机森林……

35、特征工程基础:如何用特征选择优化模型

36、调参方法:如何调节参数优化模型

37、Python数据分析包:scipy、numpy、scikit-learn等

38、在数据分析的这个阶段,重点了解回归分析的方法,大多数的问题可以得以解决,利用描述性的统计分析和回归分析,你完全可以得到一个不错的分析结论。

39、当然,随着你实践量的增多,可能会遇到一些复杂的问题,你就可能需要去了解一些更高级的算法:分类、聚类。

40、然后你会知道面对不同类型的问题的时候更适合用哪种算法模型,对于模型的优化,你需要去了解如何通过特征提取、参数调节来提升预测的精度。

41、你可以通过 Python中的 scikit-learn库来实现数据分析、数据挖掘建模和分析的全过程。

42、其实做数据挖掘不是梦,5步就能让你成为一个Python爬虫高手!

二、最受欢迎的 15 大 Python 库有哪些

1、Pandas:是一个Python包,旨在通过“标记”和“关系”数据进行工作,简单直观。它设计用于快速简单的数据操作、聚合和可视化,是数据整理的完美工具。

2、Numpy:是专门为Python中科学计算而设计的软件集合,它为Python中的n维数组和矩阵的操作提供了大量有用的功能。该库提供了NumPy数组类型的数学运算向量化,可以改善性能,从而加快执行速度。

3、SciPy:是一个工程和科学软件库,包含线性代数,优化,集成和统计的模块。SciPy库的主要功能是建立在NumPy上,通过其特定子模块提供有效的数值例程,并作为数字积分、优化和其他例程。

4、Matplotlib:为轻松生成简单而强大的可视化而量身定制,它使Python成为像MatLab或Mathematica这样的科学工具的竞争对手。

5、Seaborn:主要关注统计模型的可视化(包括热图),Seaborn高度依赖于Matplotlib。

6、Bokeh:独立于Matplotlib,主要焦点是交互性,它通过现代浏览器以数据驱动文档的风格呈现。

7、Plotly:是一个基于Web用于构建可视化的工具箱,提供API给一些编程语言(Python在内)。

Stack额外的软件包,专为像图像处理和机器学习辅助等特定功能而设计。它建立在SciPy之上,中集成了有质量的代码和良好的文档、简单易用并且十分高效,是使用Python进行机器学习的实际行业标准。

9、Theano:是一个Python软件包,它定义了与NumPy类似的多维数组,以及数学运算和表达式。此库是被编译的,可实现在所有架构上的高效运行。

10、TensorFlow:是数据流图计算的开源库,旨在满足谷歌对训练神经网络的高需求,并且是基于神经网络的机器学习系统DistBelief的继任者,可以在大型数据集上快速训练神经网络。

11、Keras:是一个用Python编写的开源的库,用于在高层的接口上构建神经网络。它简单易懂,具有高级可扩展性。

12、NLTK:主要用于符号学和统计学自然语言处理(NLP)的常见任务,旨在促进NLP及相关领域(语言学,认知科学人工智能等)的教学和研究。

13、Gensim:是一个用于Python的开源库,为有向量空间模型和主题模型的工作提供了使用工具。这个库是为了高效处理大量文本而设计,不仅可以进行内存处理,还可以通过广泛使用NumPy数据结构和SciPy操作来获得更高的效率。

三、python怎么做大数据分析

1、数据获取:公开数据、Python爬虫外部数据的获取方式主要有以下两种。(推荐学习:Python视频教程)

2、第一种是获取外部的公开数据集,一些科研机构、企业、政府会开放一些数据,你需要到特定的网站去下载这些数据。这些数据集通常比较完善、质量相对较高。

3、另一种获取外部数据的方式就是爬虫。

4、比如你可以通过爬虫获取招聘网站某一职位的招聘信息,爬取租房网站上某城市的租房信息,爬取豆瓣评分评分最高的电影列表,获取知乎点赞排行、网易云音乐评论排行列表。基于互联网爬取的数据,你可以对某个行业、某种人群进行分析。

5、在爬虫之前你需要先了解一些 Python的基础知识:元素(列表、字典、元组等)、变量、循环、函数………

6、以及,如何用 Python库(urlpb、BeautifulSoup、requests、scrapy)实现网页爬虫。

7、掌握基础的爬虫之后,你还需要一些高级技巧,比如正则表达式、使用cookie信息、模拟用户登录、抓包分析、搭建代理池等等,来应对不同网站的反爬虫限制。

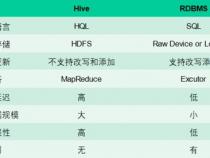

8、在应对万以内的数据的时候,Excel对于一般的分析没有问题,一旦数据量大,就会力不从心,数据库就能够很好地解决这个问题。而且大多数的企业,都会以SQL的形式来存储数据。

9、SQL作为最经典的数据库工具,为海量数据的存储与管理提供可能,并且使数据的提取的效率大大提升。你需要掌握以下技能:

10、数据的分组聚合、如何建立多个表之间的联系

11、很多时候我们拿到的数据是不干净的,数据的重复、缺失、异常值等等,这时候就需要进行数据的清洗,把这些影响分析的数据处理好,才能获得更加精确地分析结果。

12、对于数据预处理,学会 pandas(Python包)的用法,应对一般的数据清洗就完全没问题了。需要掌握的知识点如下:

13、缺失值处理:对缺失数据行进行删除或填充

14、重复值处理:重复值的判断与删除

15、异常值处理:清除不必要的空格和极端、异常数据

16、相关操作:描述性统计、Apply、直方图等

17、合并:符合各种逻辑关系的合并操作

18、分组:数据划分、分别执行函数、数据重组

19、基本统计量:均值、中位数、众数、百分位数、极值等

20、其他描述性统计量:偏度、方差、标准差、显著性等

21、其他统计知识:总体和样本、参数和统计量、ErrorBar

22、概率分布与假设检验:各种分布、假设检验流程

23、其他概率论知识:条件概率、贝叶斯等

24、有了统计学的基本知识,你就可以用这些统计量做基本的分析了。你可以使用 Seaborn、matplotpb等(python包)做一些可视化的分析,通过各种可视化统计图,并得出具有指导意义的结果。

25、掌握回归分析的方法,通过线性回归和逻辑回归,其实你就可以对大多数的数据进行回归分析,并得出相对精确地结论。这部分需要掌握的知识点如下:

26、基本的分类算法:决策树、随机森林……

27、特征工程基础:如何用特征选择优化模型

28、调参方法:如何调节参数优化模型

29、Python数据分析包:scipy、numpy、scikit-learn等

30、在数据分析的这个阶段,重点了解回归分析的方法,大多数的问题可以得以解决,利用描述性的统计分析和回归分析,你完全可以得到一个不错的分析结论。

31、当然,随着你实践量的增多,可能会遇到一些复杂的问题,你就可能需要去了解一些更高级的算法:分类、聚类。

32、然后你会知道面对不同类型的问题的时候更适合用哪种算法模型,对于模型的优化,你需要去了解如何通过特征提取、参数调节来提升预测的精度。

33、你可以通过 Python中的 scikit-learn库来实现数据分析、数据挖掘建模和分析的全过程。

34、更多Python相关技术文章,请访问Python教程栏目进行学习!以上就是小编分享的关于python怎么做大数据分析的详细内容希望对大家有所帮助,更多有关python教程请关注环球青藤其它相关文章!