Python爬虫是什么

发布时间:2025-05-11 23:06:35 发布人:远客网络

一、Python爬虫是什么

为自动提取网页的程序,它为搜索引擎从万维网上下载网页。

网络爬虫为一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索。

1、由Python标准库提供了系统管理、网络通信、文本处理、数据库接口、图形系统、XML处理等额外的功能。

2、按照网页内容目录层次深浅来爬行页面,处于较浅目录层次的页面首先被爬行。当同一层次中的页面爬行完毕后,爬虫再深入下一层继续爬行。

3、文本处理,包含文本格式化、正则表达式匹配、文本差异计算与合并、Unicode支持,二进制数据处理等功能。

参考资料来源:百度百科-网络爬虫

二、python的爬虫是什么意思

1、Python爬虫即使用Python程序开发的网络爬虫(网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。其实通俗的讲就是通过程序去获取 web页面上自己想要的数据,也就是自动抓取数据。网络爬虫(英语:web crawler),也叫网络蜘蛛(spider),是一种用来自动浏览万维网的网络机器人。其目的一般为编纂网络索引。

2、网络搜索引擎等站点通过爬虫软件更新自身的网站内容或其对其他网站的索引。网络爬虫可以将自己所访问的页面保存下来,以便搜索引擎事后生成索引供用户搜索。

3、爬虫访问网站的过程会消耗目标系统资源。不少网络系统并不默许爬虫工作。因此在访问大量页面时,爬虫需要考虑到规划、负载,还需要讲“礼貌”。不愿意被爬虫访问、被爬虫主人知晓的公开站点可以使用robots.txt文件之类的方法避免访问。这个文件可以要求机器人只对网站的一部分进行索引,或完全不作处理。

4、互联网上的页面极多,即使是最大的爬虫系统也无法做出完整的索引。因此在公元2000年之前的万维网出现初期,搜索引擎经常找不到多少相关结果。现在的搜索引擎在这方面已经进步很多,能够即刻给出高质量结果。

5、爬虫还可以验证超链接和HTML代码,用于网络抓取。

6、Python爬虫架构主要由五个部分组成,分别是调度器、URL管理器、网页下载器、网页解析器、应用程序(爬取的有价值数据)。

7、调度器:相当于一台电脑的 CPU,主要负责调度 URL管理器、下载器、解析器之间的协调工作。

8、URL管理器:包括待爬取的 URL地址和已爬取的 URL地址,防止重复抓取 URL和循环抓取 URL,实现 URL管理器主要用三种方式,通过内存、数据库、缓存数据库来实现。

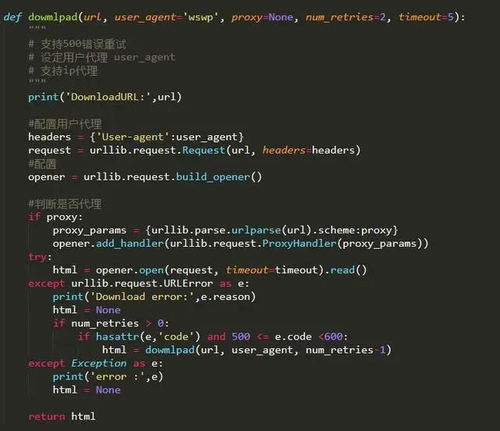

9、网页下载器:通过传入一个 URL地址来下载网页,将网页转换成一个字符串,网页下载器有 urlpb2(Python官方基础模块)包括需要登录、代理、和 cookie,requests(第三方包)

10、网页解析器:将一个网页字符串进行解析,可以按照我们的要求来提取出我们有用的信息,也可以根据 DOM树的解析方式来解析。网页解析器有正则表达式(直观,将网页转成字符串通过模糊匹配的方式来提取有价值的信息,当文档比较复杂的时候,该方法提取数据的时候就会非常的困难)、html.parser(Python自带的)、beautifulsoup(第三方插件,可以使用 Python自带的 html.parser进行解析,也可以使用 lxml进行解析,相对于其他几种来说要强大一些)、lxml(第三方插件,可以解析 xml和 HTML),html.parser和 beautifulsoup以及 lxml都是以 DOM树的方式进行解析的。

11、应用程序:就是从网页中提取的有用数据组成的一个应用。

12、你可以用爬虫爬图片,爬取视频等等你想要爬取的数据,只要你能通过浏览器访问的数据都可以通过爬虫获取。

13、模拟浏览器打开网页,获取网页中我们想要的那部分数据

14、当你在浏览器中输入地址后,经过 DNS服务器找到服务器主机,向服务器发送一个请求,服务器经过解析后发送给用户浏览器结果,包括 html,js,css等文件内容,浏览器解析出来最后呈现给用户在浏览器上看到的结果

15、所以用户看到的浏览器的结果就是由 HTML代码构成的,我们爬虫就是为了获取这些内容,通过分析和过滤 html代码,从中获取我们想要资源。

16、相关推荐:《Python教程》以上就是小编分享的关于python的爬虫是什么意思的详细内容希望对大家有所帮助,更多有关python教程请关注环球青藤其它相关文章!

三、python爬虫是怎样的一回事。

从爬虫必要的几个基本需求来讲:

py的urllib不一定去用,但是要学,如果还没用过的话。

比较好的替代品有requests等第三方更人性化、成熟的库,如果pyer不了解各种库,那就白学了。

如果深入做下去,会发现要面对不同的网页要求,比如有认证的,不同文件格式、编码处理,各种奇怪的url合规化处理、重复抓取问题、cookies跟随问题、多线程多进程抓取、多节点抓取、抓取调度、资源压缩等一系列问题。

所以第一步就是拉网页回来,慢慢会发现各种问题待优化。

抓回来一般会用一定策略存下来,而不是直接分析,个人觉得更好的架构应该是把分析和抓取分离,更加松散,每个环节出了问题能够隔离另外一个环节可能出现的问题,好排查也好更新发布。

那么存文件系统、SQLorNOSQL数据库、内存数据库,如何去存就是这个环节的重点。

可以选择存文件系统开始,然后以一定规则命名。

对网页进行文本分析,提取链接也好,提取正文也好,总之看的需求,但是一定要做的就是分析链接了。

可以用认为最快最优的办法,比如正则表达式。

然后将分析后的结果应用与其他环节:)

要是做了一堆事情,一点展示输出都没有,如何展现价值。

所以找到好的展示组件,去show出肌肉也是关键。

如果为了做个站去写爬虫,抑或要分析某个东西的数据,都不要忘了这个环节,更好地把结果展示出来给别人感受。