FlinkCDC数据实时同步Mysql到ES

发布时间:2025-05-21 02:00:01 发布人:远客网络

一、FlinkCDC数据实时同步Mysql到ES

当需要将数据库数据实时同步到其他系统,如Elasticsearch,一个高效的方法是利用Apache Flink的CDC(Change Data Capture)技术。Flink CDC通过监控数据库日志,捕获数据的增删改操作,并实时将这些变化数据传输到目标系统,满足高实时性的需求。Flink CDC凭借Flink的强大实时处理能力,支持集群部署和高可用性,且与MySQL、Oracle、MongoDB等主流数据库兼容,其Java实现为开发者提供了灵活的开发环境和源码可定制性。

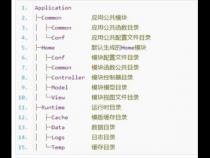

例如,通过Flink SQL,仅需寥寥几行代码就能实现MySQL数据到Elasticsearch的实时同步。首先,确保安装了相关的Flink和SQL插件,如flink-1.15.0和flink-sql-connector-组件。启动Flink后,通过窗口功能创建与MySQL的连接表,以及与Elasticsearch同步的表。接着编写SQL任务,任务运行后,MySQL的数据即可实时流入Elasticsearch。此外,Flink CDC还支持其他数据源,如Oracle、MongoDB等,可以灵活地通过Kafka等中间件进行进一步处理和分发。

想了解更多关于Flink CDC的细节和使用方法,可以参考以下链接:

通过以上Flink CDC的介绍,实时同步MySQL到Elasticsearch的任务变得简单而强大。

二、flink-cdc同步mysql数据到kafka

Flink CDC技术是用于实时捕获数据库变更数据的关键工具,它记录数据表的插入、更新和删除操作,然后将这些变化以有序的方式推送到消息中间件,以支持其他服务订阅和处理。以下是如何将MySQL数据同步到Kafka的步骤。

如果没有安装Hadoop,可以选择使用Flink standalone模式。

从指定地址下载flink的依赖,特别是flink-sql-connector-mysql-cdc。初始版本为1.4,但后来发现1.3.0更适合,因为它与connector-kafka兼容性更好。对于更高版本的Flink,可以选择从github下载源码自行编译,但这里推荐使用1.3版本的jar包。

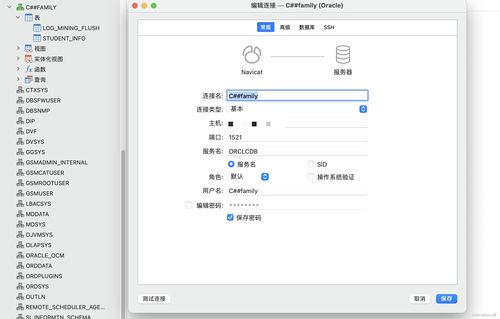

在YARN上启动Flink application,进入flink目录并执行相关命令,然后切换到Flink SQL命令行。

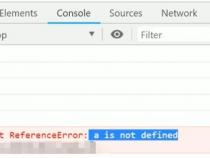

首先,创建一个MySQL表,并在Flink SQL中与之关联,这样操作此表就像操作MySQL表一样。接着,设置数据表与Kafka的关联,例如创建名为product_view_kafka_sink的主题,数据同步会自动触发。执行SQL同步任务后,可以在Flink web-ui中看到MySQL数据已被同步到Kafka,MySQL的插入操作将实时反映在Kafka中。

通过Kafka控制台验证数据同步,确认数据已从MySQL成功同步至Kafka。

进一步的信息可以参考ververica.github.io/fli...。

三、flink高效读写clickhouse

1、在处理大量数据时,面对ClickHouse等列式数据库中数据的内存限制问题,有多种策略可供选择。以下是几种有效方法:

2、利用ClickHouse的计算能力,因其设计用于快速分析,故通常直接在ClickHouse中执行SQL查询,实现复杂分析与聚合操作,无需额外数据移动。

3、采用分批处理策略,将数据划分为多个批次,每次处理一部分数据,以此解决内存限制问题。

4、结合Apache Flink,一个高效分布式流处理框架,实现批处理ClickHouse数据。Flink能通过自定义SourceFunction直接从ClickHouse读取数据,或使用现有的Flink-ClickHouse connector。

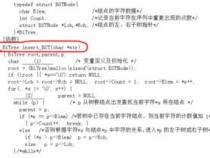

5、示例展示如何在Flink中实现自定义SourceFunction,分批读取ClickHouse数据进行简单处理。假设任务为读取包含用户信息的表,表中包括id(整型)和name(字符串)两列。

6、确保项目中已添加Flink与ClickHouse的JDBC驱动依赖。pom.xml中可能的依赖配置如下:

7、定义数据模型时,创建简单Java类表示用户信息。

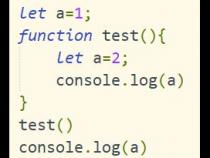

8、实现自定义SourceFunction,模拟分批读取数据逻辑。使用Thread.sleep()简化示例,实际应用需调整批处理逻辑与参数。

9、在Flink应用程序中使用自定义source function读取数据。实际应用中,需根据数据分布情况调整分批策略。

10、请注意,示例中的Thread.sleep()用于简化,生产环境应根据实际情况调整批处理间隔。确保优化批处理逻辑与参数以适应具体需求。