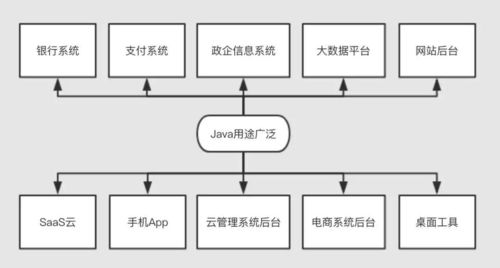

java应用程序集成hanLP实现自然语言分词+match(mysql)

发布时间:2025-05-20 22:06:25 发布人:远客网络

一、java应用程序集成hanLP实现自然语言分词+match(mysql)

自然语言处理(NLP)是一门将计算机科学与语言学相结合的交叉学科,旨在利用计算模型解析、理解及生成人类语言。NLP涉及词性标注、命名实体识别、句法分析等多个任务,旨在实现语言的自动化处理。

自然语言分词是NLP的基础,旨在将连续的文本分割成独立的词语或词素。例如,句子“你好美丽的祖国大地,你好美丽的大好河山”在分词后变为“你好美丽的祖国大地,你好美丽的大好河山”,这有助于计算机理解其结构。

实现自然语言分词的框架众多,如SnowNLP、Thulac、HanLP、LTP和CoreNLP等。HanLP是一个面向生产环境的多语言自然语言处理工具包,基于PyTorch和TensorFlow 2.x双引擎,提供全面的NLP功能,包括词干提取、分词、词性标注、命名实体识别等。

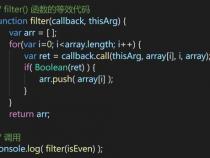

Java应用程序集成HanLP实现自然语言分词通常涉及以下几个步骤。首先,下载汉LP的语言包,并将其解压并放置在指定目录。随后,在资源文件夹中创建hanlp.properties配置文件,指定语言包根目录。接着,编写Java代码,包括Word类、Tokenizer类和TokenizerTester类,用于处理文本分词。

在代码中,首先引入POM依赖,然后编写分词代码,输入字符串“你好美丽的祖国大地,你好美丽的大好河山”,输出结果应按照中文分词规则进行正确分割。

值得一提的是,HanLP在数据处理与拆分比例、命名实体识别、语法标准及语料库等方面提供了改进与优化,致力于推动中文NLP的透明化与个性化训练。通过集成HanLP,数据库可以增加FULLTEXT类型索引,解决中文全文索引不适用的问题,以提高检索效率。

综上所述,通过Java应用程序集成HanLP实现自然语言分词,可以有效提高文本处理的准确性和效率,满足不同应用场景的需求,同时支持个性化词库训练,增强系统适应性和灵活性。

二、Elasticsearch安装以及配置hanlp中文分词插件

elasticsearch默认开启两个端口:9200,用于ES节点和外部通讯;9300,用于ES节点之间通讯

报错: org.elasticsearch.bootstrap.StartupException: java.lang.RuntimeException: can not run elasticsearch as root,不能以root用户的身份运行elasticsearch

解决方法:新建用户组和用户,并赋予其elasticsearch文件夹的权限

WARN: java.lang.UnsupportedOperationException: seccomp unavailable: CONFIG_SECCOMP not compiled into kernel, CONFIG_SECCOMP and CONFIG_SECCOMP_FILTER are needed,使用新的linux版本即可,不影响使用

启动失败,出现上面四个错误,一一解决

ERROR[1]:无法创建本地文件问题,用户最大可创建文件数太小

解决方法:切换到root用户,编辑limits.conf配置文件

ERROR[2]:无法创建本地线程问题,用户最大可创建线程数太小

解决方法:切换到root用户,进入limits.d目录下,修改90-nproc.conf配置文件

解决方法:切换到root用户下,修改配置文件sysctl.conf

ERROR[4]:这是在因为Centos6不支持SecComp,而ES5.2.0默认bootstrap.system_call_filter为true进行检测,所以导致检测失败,失败后直接导致ES不能启动

解决方法:在elasticsearch.yml中配置bootstrap.system_call_filter为false

解决完成后,重新启动,启动成功

如果要在后台运行,使用./bin/elasticsearch-d启动

访问 ,返回数据

现在启动elasticsearch,提示jar包冲突

现在启动elasticsearch,没有异常,我们测试一下hanlp分词插件有没有生效

访问:

elasticsearch报错并且退出运行

看上去是权限的问题,这就用到hanlp目录下的 plugin-security.policy文件,修改/elasticsearch/config/jvm.options文件,在末尾添加

继续测试上面的链接,提示找不到hanlp.properties,hanlp无法加载词典,elasticsearch退出运行,解决方法:修改/elasticsearch/bin/elasticsearch.in.sh文件,将ES_CLASSPATH修改为:

继续测试上面的链接,访问成功,返回结果

可以看到分词效果比较好,而且停用词也被过滤了,大功告成!