一文搞定 WebRTC丨Android 客户端编译

发布时间:2025-05-13 07:47:22 发布人:远客网络

一、一文搞定 WebRTC|Android 客户端编译

1、前言:本文介绍如何在Android客户端编译WebRTC,包括编译前的准备工作、编译步骤、以及解决常见问题的方法。编译过程涉及环境配置、下载源码、同步目标分支、安装编译依赖、设置编译参数、生成ninja文件,以及启动编译流程。本文以m84分支为例,介绍其他分支可能遇到的差异。

2、准备工作:安装depot_tools工具,这是编译WebRTC源码的关键。设置环境变量以确保工具可被访问。验证环境配置是否正确。

3、源码下载与同步:获取WebRTC源码,考虑到源码大小(约18G),建议使用稳定代理。同步至目标分支以获取最新版本。

4、源码编译:安装编译所需的依赖(约30分钟)。设置gn生成器,生成ninja文件。进入src目录,指定编译参数,如target_os为android、target_cpu为arm、is_debug为false,开始编译。编译过程中将执行多个构建任务,耗时约2小时。

5、非全量编译:编译过程中,可以选择非全量编译以提高效率。

6、验证:生成的aar文件可用性验证。可导入到WebRTC的官方demo中,测试其功能。

7、配置Android Studio工程:使用Android Studio打开包含aar文件的工程,编辑app/build.gradle文件,替换原有依赖为编译生成的libwebrtc.aar。

8、Q&A:解决编译过程中遇到的常见问题,如Python版本不兼容、编译错误等。需要确保使用m84分支所需的Python2版本进行编译。对于编译错误“ERROR: The installation of the Chrome OS default fonts failed.”,可能需要重新安装依赖。针对M89/4389分支编译aar时遇到的错误,可参考官方文档或论坛讨论。

9、WebRTC官网、Android|WebRTC文档提供详细的编译指南和资源,可作为参考。构建全国最权威的音视频技术交流分享论坛,提供更多学习资料和社区支持,帮助开发者解决实际问题。

二、ubuntu18.04编译webrtc_android库

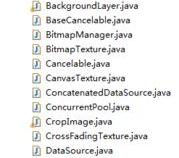

本文介绍了基于Ubuntu 18.04编译Android版本的WebRTC库的过程,旨在为其他平台的开发者提供参考。在编译WebRTC之前,首先需要安装depot_tools工具包,它包含了gclient、gcl、git-cl、repo等工具,用于管理项目源码、分发及编译等任务。

为了方便使用depot_tools命令,建议将depot_tools路径添加到环境变量PATH中。具体步骤为:在.bashrc或.zshrc文件中,加入相应的命令行指令。然后同步WebRTC代码,通常使用gclient工具完成,它能管理多模块依赖的项目源码版本。

在同步代码过程中,如果遇到fetch错误,可能会导致只能看到master、infra/config以及lkgr等几个分支。为了解决这个问题,需要修改仓库的.git/config文件,在[remote"origin"]节中添加特定内容。这样能确保看到所有branch-heads的分支。

选择源码版本时,应尽量选择稳定版本分支,通常可以在官方网站上查看到。我这里选择的是M108分支进行编译。

进行编译时,需要使用gn工具进行配置。在编译命令中,包含target_os和target_cpu参数。注意,编译过程可能需要较长的时间,因为涉及到大量的目录编译,通常需要1~2小时。

在编译过程中,可能会遇到一些常见错误,比如在third_party/ffmpeg/libavutil/arm/cpu.c文件中调用未声明的函数getauxval。解决方法是检查头文件auxv.h,它定义在android交叉编译环境中,并且声明了函数的API版本为18及以上。对于32位版本,需要在编译时指定android32_ndk_api_level为18。

另外,如果在使用dataclasses模块时遇到问题,可能是由于python版本过低。在Ubuntu 18.04上,若发现使用的是python3.6版本,建议通过apt-get安装python3.8,并使用update-alternatives进行版本切换,以便解决与dataclasses模块相关的兼容性问题。

以上是基于Ubuntu 18.04编译WebRTC Android库的详细步骤和常见问题解答,希望能对开发者有所帮助。

三、WebRTC 实现 Android 传屏 demo

1、WebRTC是一项实时通讯技术,允许网络应用或站点在浏览器之间不借助中间媒介实现点对点的连接,传输视频流、音频流或其他任意数据。在Android平台上集成WebRTC框架,可以实现强大的音视频传输功能,只需简洁的代码即可。

2、为了实现Android平台的WebRTC demo,并实现两端局域网传屏功能,我们需要搭建相关环境和配置。首先,通过导入WebRTC官方的aar包,方便地引入官方提供的so与java层sdk代码。若需要自行编译aar,可以参考官方源码中的脚本生成本地aar或发布到maven仓库。

3、在使用PeerConnectionFactory之前,必须进行全局初始化与资源加载,通过调用静态方法initialize()并传入InitializationOptions进行配置。完成初始化后,可以创建PeerConnectionFactory实例,这个工厂类在后续的音视频采集、编解码等操作中扮演重要角色。通过Builder模式进行初始化,方便设置编解码器。

4、创建PeerConnection对象是点对点连接的起点,它可以从远端获取音视频流等数据。在创建之前,可以通过RTCConfiguration对连接进行详细配置。同时,通过Factory创建音视频数据源,如AudioSource和VideoSource,但数据来源需在外部实现,如从音频设备捕获或通过特定接口获取视频流。

5、对于视频流,WebRTC提供了多种获取方式,如ScreenCapturerAndroid、CameraCapturer和FileVideoCapturer。通过startCapture()方法开始获取数据,并通过CapturerObserver进行回调。创建VideoTrack和AudioTrack后,通过PeerConnection添加到连接中,以便生成包含相应媒体信息的SDP。

6、建立信令服务器是交换SDP信息的关键步骤。对于局域网场景,可直接使用java Socket实现TCPChannelClient。在进行媒体协商前,需要交换编解码器、传输协议等信息,确保双方支持后,连接才能成功建立。

7、媒体协商过程包括创建Offer和Answer SDP,由呼叫方发起Offer请求,被呼叫方接收并创建Answer回复。当协商成功后,PeerConnection会尝试进行连接,优先选择host方式实现内网间连通。

8、在点对点连接建立后,开始获取音视频流数据。通过onAddStream()回调接收远端的MediaStream对象,其中包含AudioTracks与VideoTracks。通过addSink()与SurfaceViewRenderer绑定,展示远端视频流。

9、在WebRTC中,JavaAudioDeviceModule用于实现音视频的录制与播放,底层采用AudioRecord和AudioTrack。创建PeerConnectionFactory时设置AudioDeviceModule即可。

10、DataChannel专门用于传输音视频流外的数据,如实时文字聊天、文件传输等。通过DataChannel.send()方法相互发送数据,onMessage()回调获取远端发送的数据。DataChannel的创建方式包括In-band与Out-of-band协商,后者在绑定ID一致时更为简便。